Nach einer gewissen Skepsis und Anlaufschwierigkeiten setzen auch immer deutsche Unternehmen auf Cloud-Lösungen. Auf dem Gartner Hype Cycle befindet sich dieser Trend auf einem Plateau der Produktivität. Ein Großteil der Unternehmen hat bereits Anwendungen in der Cloud, definiert eine Cloud-Strategie und diskutiert über die Verlagerung weiterer Applikationen in die Cloud.

Datenvirtualisierung als praktikablen Ansatz für einen vereinfachten Weg in die Cloud und die Minimierung der Downtime zeigte das Online-Seminar, das der TDWI gemeinsam mit Denodo Anfang März präsentierte.

Natürlich geht dies auch mit Herausforderungen einher, wie zum Beispiel im Bereich Security, Governance und in der Vertragsgestaltung. Tatsächlich sind die meisten Unternehmen nicht „in der Cloud geboren“, sondern bringen historisch bedingt eine Reihe von On-Premise-Systemen mit. Ihre Reise in die Cloud startet meist mit einer komplexen Architektur aus Systemen und Datenflüssen. Der Weg in die Cloud ist dann oft ein längerfristiges Unterfangen, das die Herausforderung birgt, cloud-basierte Systeme mit den on-premise betriebenen zu konnektieren.

Insofern ist es nicht überraschend, dass auch in Rahmen des Denodo Global Cloud Survey (https://www.denodo.com/en/document/whitepaper/denodo-global-cloud-survey-2019) ein signifikanter Anteil von etwa 46 Prozent der befragten Unternehmen angibt, sich in einem Hybrid-Cloud-Szenario zu befinden. Diese Unternehmen haben zwar einen Teil ihrer Anwendungen bereits in der Cloud, andere Teile befinden sich aber noch on-premise und/oder in anderen Clouds. Als wichtige Herausforderung nennen die befragten Unternehmen dabei, dass einerseits die Datenzugriffe und Schnittstellen mit der über Clouds und on-premise verteilten Infrastruktur komplexer werden. Zum anderen bekommt Datensicherheit eine immer zentralere Bedeutung, insbesondere auch wegen steigender regulativer Anforderungen. Des weiteren explodiert die Anzahl von Third-Party-Anwendungen geradezu, sodass immer mehr Integrationen realisiert werden müssen.

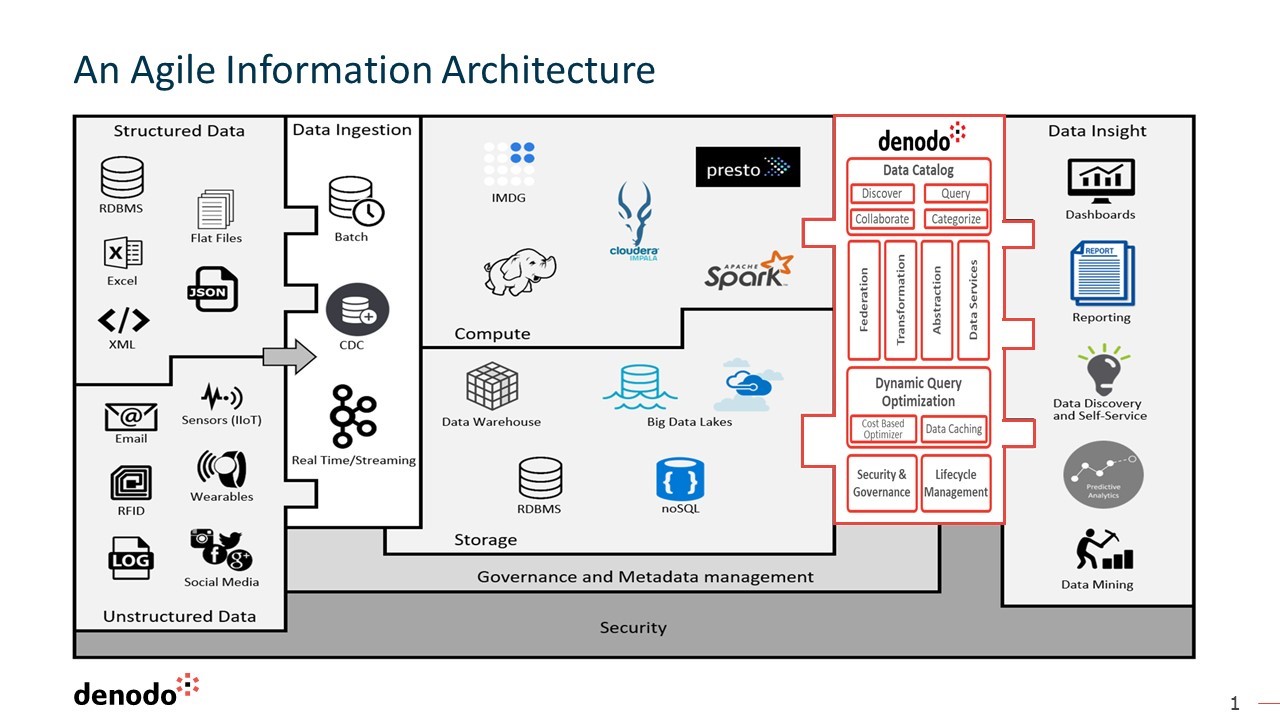

In diesem Kontext kann Datenvirtualisierung zu einer agilen Infrastruktur verhelfen.

Die Datenvirtualisierung wird als Schicht zwischen den Konsumenten der Daten und den eigentlichen Datenquellen eingezogen. Dabei wird nicht nur der Zugriff abstrahiert, sondern über diese Ebene auch ein Zugang zu Meta-Informationen, zum Beispiel im Rahmen eines Data Catalogs, etabliert. Ebenso können Security- und Governance-Anforderungen zentral in dieser Schicht umgesetzt werden. Endanwender müssen nicht mehr wissen, wo Daten konkret liegen, sondern beziehen diese über die Abstraktionsschicht der Datenvirtualisierung.

Ein weiterer Vorteil für den Weg in die Cloud: Stellen Sie sich vor, ein Unternehmen tauscht Teile seiner E-Business Suite aus und möchte mit dem Anbieterwechsel von einer On-Premise-Lösung in die Cloud umziehen. Wird der Datenzugang über die Datenvirtualisierung realisiert, ist ein modularer Umstieg möglich, ohne dass sich für die Endanwender der Zugang zu den Daten verändert. Die Nutzer der Daten merken hier also gar nichts vom Wandel der Module und deren Umzug in die Cloud; sie können die Daten unverändert und ohne Downtime konsumieren.

Anhand eines konkreten Kundenbeispiels – logitech – wurde im Online-Seminar illustriert, wie ein Unternehmen ein Enterprise Data Warehouse mit Skalierungsproblemen in die Cloud umgezogen und den Endanwendern einen einheitlichen Zugang zu Daten gewährt hat, unabhängig davon, ob diese in der Cloud sind oder on-premise. Auch hier ist die Datenvirtualisierung der Schlüssel, konkret wurde denodo als Abstraktionsschicht verwendet.

Ähnliche Vorteile ergeben sich in Hybrid-Cloud-Szenarien. Der Schwerpunkt der Daten verlagert sich zunehmend in die Cloud, wobei Unternehmen häufig auf Lösungen unterschiedlicher Cloud-Anbieter setzen. In der Folge verteilen sich Daten auf on-premise und unterschiedliche Clouds. Für viele Auswertungen müssen diese Daten jedoch zusammenspielen. Hier hilft die „Multi Location Architecture“ von denodo, die über eine Abstraktionsschicht einen zentralen Zugang zu Daten unabhängig von ihrem konkreten Speicherort gewährt. Wichtig bei der technischen Umsetzung ist dabei, dass denodo im Hintergrund Abfragen so organisiert, dass der Transport von Daten zwischen Clouds minimiert und gleichzeitig die Abfrage performant gestaltet wird.

Zusammenfassend wurde ein Konzept präsentiert, das den Grundideen der Schichtenbildung mit einem „separation of concerns“ (Trennung von Zuständigkeiten) gerecht wird: Über eine Virtualisierungsschicht werden die Daten von einem konkreten Speicherort abstrahiert, sodass dieser auch ohne Auswirkungen für die Datennutzer verändert werden kann. Dadurch werden gleichzeitig Downtimes reduziert und Systeme oder Module können für die Datenkonsumenten unsichtbar verändert werden.

Erfahren Sie, wie QuinScape Sie auf dem Weg in die Cloud begleitet:

QuinScape GmbH

Tanja Menke

Wittekindstraße 30

44139 Dortmund

+49 231 / 533 831 259

tanja.menke@quinscape.de

![BLOG | Logisches Datenmanagement: Der Schlüssel zum Erfolg in datenzentrierten Zeiten – mit Richard Walker von Denodo [Datenhelden]](https://www.quinscape.de/wp-content/uploads/2023/10/Richard-Walker-Blogbeitrag-500x383.png)

![BLOG | Datenvirtualisierung: Zentraler Zugriff auf verteilte Daten – mit Paul Moxon von Denodo [Datenhelden]](https://www.quinscape.de/wp-content/uploads/2022/11/2022-Datenhelden-Interview-Moxon-500x383.jpg)